Hugging Facen 'tietojoukot' -kirjasto tarjoaa kätevän tavan käsitellä ja käsitellä tietojoukkoja luonnollisen kielen käsittelytehtäviä varten. Yksi hyödyllinen kirjaston tarjoama toiminto on concatenate_datasets(), jonka avulla voit ketjuttaa useita tietojoukkoja yhdeksi tietojoukoksi. Seuraavassa on lyhyt yleiskatsaus concatenate_datasets()-funktiosta ja sen käytöstä.

concatenate_datasets()

Kuvaus:

Hugging Facen 'datasets'-kirjasto tarjoaa concatenate_datasets() -toiminnon. Sitä käytetään useiden tietojoukkojen yhdistämiseen yhdistämällä ne yhdeksi tietojoukoksi määrättyä akselia pitkin. Tämä toiminto on erityisen hyödyllinen, kun sinulla on useita tietojoukkoja, joilla on sama rakenne ja haluat yhdistää ne yhtenäiseksi tietojoukoksi jatkokäsittelyä ja analysointia varten.

Syntaksi:

alkaen tietojoukot tuonti concatenate_datasets

ketjutettu_tietojoukko = concatenate_datasets ( tietojoukot , akseli = 0 , tiedot = Ei mitään )

Parametrit:

tietojoukot (tietojoukon luettelo): Luettelo tietojoukoista, jotka haluat ketjuttaa. Näissä tietojoukoissa tulee olla yhteensopivia ominaisuuksia, mikä tarkoittaa, että niillä on sama skeema, sarakkeiden nimet ja tietotyypit.

akseli (int, valinnainen, oletus=0): Akseli, jota pitkin ketjutus tulee suorittaa. Useimmissa NLP-tietojoukoissa käytetään oletusarvoa 0, mikä tarkoittaa, että tietojoukot ketjutetaan pystysuunnassa. Jos asetat akseliksi = 1, tietojoukot ketjutetaan vaakasuunnassa olettaen, että niillä on eri sarakkeita ominaisuuksia.

tiedot (datasets.DatasetInfo, valinnainen): Tiedot ketjutetusta tietojoukosta. Jos tietoja ei anneta, tiedot päätellään luettelon ensimmäisestä tietojoukosta.

Palautukset:

ketjutettu_tietojoukko (Tietojoukko): Tuloksena oleva tietojoukko kaikkien syötettyjen tietojoukkojen yhdistämisen jälkeen.

Esimerkki:

# Vaihe 1: Asenna tietojoukkokirjasto# Voit asentaa sen pip:llä:

# !pip asennustietojoukot

# Vaihe 2: Tuo vaaditut kirjastot

alkaen tietojoukot tuonti load_dataset , concatenate_datasets

# Vaihe 3: Lataa IMDb-elokuvakatsaustietojoukot

# Käytämme kahta IMDb-tietojoukkoa, toista myönteisiä arvosteluja varten

#ja toinen negatiivisille arvosteluille.

# Lataa 2500 positiivista arvostelua

dataset_pos = load_dataset ( 'imdb' , jakaa = 'juna[:2500]' )

# Lataa 2500 negatiivista arvostelua

dataset_neg = load_dataset ( 'imdb' , jakaa = 'juna[-2500:]' )

# Vaihe 4: Liitä tietojoukot yhteen

# Yhdistämme molemmat tietojoukot pitkin akseli = 0, kuten ne ovat tehneet

sama kaava ( samat ominaisuudet ) .

ketjutettu_tietojoukko = concatenate_datasets ( [ dataset_pos , dataset_neg ] )

# Vaihe 5: Analysoi ketjutettu tietojoukko

# Yksinkertaisuuden vuoksi lasketaan positiivisten ja negatiivisten määrä

# arvostelua ketjutetussa tietojoukossa.

positiivisten_arvostelujen määrä = summa ( 1 varten etiketti sisään

ketjutettu_tietojoukko [ 'etiketti' ] jos etiketti == 1 )

negatiivisten_arvostelujen määrä = summa ( 1 varten etiketti sisään

ketjutettu_tietojoukko [ 'etiketti' ] jos etiketti == 0 )

# Vaihe 6: Näytä tulokset

Tulosta ( 'Myönteisten arvostelujen määrä:' , positiivisten_arvostelujen määrä )

Tulosta ( 'Negatiivisten arvostelujen määrä:' , negatiivisten_arvostelujen määrä )

# Vaihe 7: Tulosta muutama esimerkkiarvostelu ketjutetusta tietojoukosta

Tulosta ( ' \n Muutama esimerkki arvostelusta:' )

varten i sisään alue ( 5 ) :

Tulosta ( f 'Tarkista {i + 1}: {concatenated_dataset['text'][i]}' )

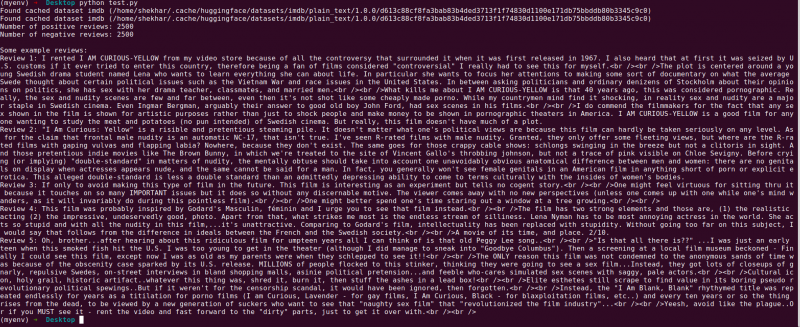

Lähtö:

Seuraavassa on selitys Hugging Facen 'tietojoukot' -kirjastoohjelmalle, joka yhdistää kaksi IMDb-elokuvakatsaustietojoukkoa. Tämä selittää ohjelman tarkoituksen, sen käytön ja koodin vaiheet.

Annamme yksityiskohtaisemman selityksen koodin jokaisesta vaiheesta:

# Vaihe 1: Tuo vaaditut kirjastotalkaen tietojoukot tuonti load_dataset , concatenate_datasets

Tässä vaiheessa tuomme ohjelmalle tarvittavat kirjastot. Tarvitsemme 'load_dataset'-funktion ladatakseen IMDb-elokuvakatselun tietojoukot ja 'concatenate_datasets'-funktion ketjuttaaksemme ne myöhemmin.

# Vaihe 2: Lataa IMDb Movie Review Datasets# Lataa 2500 positiivista arvostelua

dataset_pos = load_dataset ( 'imdb' , jakaa = 'juna[:2500]' )

# Lataa 2500 negatiivista arvostelua

dataset_neg = load_dataset ( 'imdb' , jakaa = 'juna[-2500:]' )

Tässä käytämme 'load_dataset' -funktiota IMDb-tietojoukon kahden osajoukon hakemiseen. 'Dataset_pos' sisältää 2500 positiivista arvostelua ja 'dataset_neg' sisältää 2500 negatiivista arvostelua. Käytämme split-parametria määrittääksemme ladattavien esimerkkien joukon, jolloin voimme valita koko tietojoukon osajoukon.

# Vaihe 3: Yhdistä tietojoukotketjutettu_tietojoukko = concatenate_datasets ( [ dataset_pos , dataset_neg ] )

Tässä vaiheessa ketjutamme IMDb-tietojoukon kaksi osajoukkoa yhdeksi tietojoukoksi nimeltä 'concatenated_dataset'. Käytämme 'concatenate_datasets' -funktiota ja välitämme sen luettelon kanssa, joka sisältää kaksi ketjutettavaa tietojoukkoa. Koska molemmilla tietojoukoilla on samat ominaisuudet, ketjutamme ne akseli=0 pitkin, mikä tarkoittaa, että rivit pinotaan päällekkäin.

# Vaihe 4: Analysoi ketjutettu tietojoukkopositiivisten_arvostelujen määrä = summa ( 1 varten etiketti sisään

ketjutettu_tietojoukko [ 'etiketti' ] jos etiketti == 1 )

negatiivisten_arvostelujen määrä = summa ( 1 varten etiketti sisään

ketjutettu_tietojoukko [ 'etiketti' ] jos etiketti == 0 )

Täällä suoritamme yksinkertaisen analyysin ketjutetusta tietojoukosta. Käytämme luettelon ymmärtämistä yhdessä 'summa'-funktion kanssa laskeaksemme positiivisten ja negatiivisten arvostelujen määrän. Toistamme läpi ' label' -sarakkeessa 'concatenated_dataset' ja lisää lukemia aina, kun kohtaamme positiivisen tunnisteen (1) tai negatiivisen tunnisteen (0).

# Vaihe 5: Näytä tuloksetTulosta ( 'Myönteisten arvostelujen määrä:' , positiivisten_arvostelujen määrä )

Tulosta ( 'Negatiivisten arvostelujen määrä:' , negatiivisten_arvostelujen määrä )

Tässä vaiheessa tulostamme analyysimme tulokset – positiivisten ja negatiivisten arvostelujen lukumäärän ketjutetussa tietojoukossa.

# Vaihe 6: Tulosta muutama esimerkkiarvosteluTulosta ( ' \n Muutama esimerkki arvostelusta:' )

varten i sisään alue ( 5 ) :

Tulosta ( f 'Tarkista {i + 1}: {concatenated_dataset['text'][i]}' )

Lopuksi esittelemme muutamia esimerkkiarvosteluja ketjutetusta tietojoukosta. Käymme läpi tietojoukon viisi ensimmäistä esimerkkiä ja tulostamme niiden tekstisisällön 'teksti'-sarakkeen avulla.

Tämä koodi näyttää suoraviivaisen esimerkin Hugging Facen 'tietojoukkokirjaston' käyttämisestä IMDb-elokuvakatsaustietosarjojen lataamiseen, ketjuttamiseen ja analysoimiseen. Se korostaa kirjaston kykyä virtaviivaistaa NLP-tietojoukon käsittelyä ja esittelee sen mahdollisuuksia kehittää kehittyneempiä luonnollisen kielen käsittelymalleja ja sovelluksia.

Johtopäätös

Python-ohjelma, joka käyttää Hugging Facen 'tietojoukot' -kirjastoa, osoittaa onnistuneesti kahden IMDb-elokuvakatsaustietojoukon yhdistämisen. Lataamalla positiivisten ja negatiivisten arvostelujen osajoukot, ohjelma yhdistää ne yhdeksi tietojoukoksi käyttämällä concatenate_datasets()-funktiota. Sitten se tekee yksinkertaisen analyysin laskemalla positiivisten ja negatiivisten arvostelujen lukumäärän yhdistetyssä tietojoukossa.

'Datasets'-kirjasto yksinkertaistaa NLP-tietosarjojen käsittelyä ja käsittelyä, mikä tekee siitä tehokkaan työkalun tutkijoille, kehittäjille ja NLP-harjoittajille. Käyttäjäystävällisen käyttöliittymän ja laajojen toimintojensa ansiosta kirjasto mahdollistaa vaivattoman tietojen esikäsittelyn, tutkimisen ja muuntamisen. Tässä dokumentaatiossa esitelty ohjelma on käytännöllinen esimerkki siitä, kuinka kirjastoa voidaan hyödyntää tietojen ketjutus- ja analysointitehtävien virtaviivaistamiseksi.

Tosielämän skenaarioissa tämä ohjelma voi toimia perustana monimutkaisemmille luonnollisen kielen käsittelytehtäville, kuten tunneanalyysille, tekstin luokittelulle ja kielen mallintamiselle. 'Datasets'-kirjaston avulla tutkijat ja kehittäjät voivat hallita tehokkaasti laajamittaisia tietojoukkoja, helpottaa kokeilua ja nopeuttaa huippuluokan NLP-mallien kehitystä. Kaiken kaikkiaan Hugging Face -tietojoukot -kirjasto on olennainen voimavara pyrittäessä parantamaan luonnollisen kielen käsittelyä ja ymmärtämistä.