Tämä viesti havainnollistaa LangChain-sovellusten rakentamisprosessia käyttämällä kehotemallia ja tulospareria.

Kuinka rakentaa LangChain-sovelluksia käyttämällä kehotemallia ja tulospareria?

Jos haluat rakentaa LangChain-sovelluksen kehotemallin ja tulosten jäsentimen avulla, käy läpi tämä helppo opas:

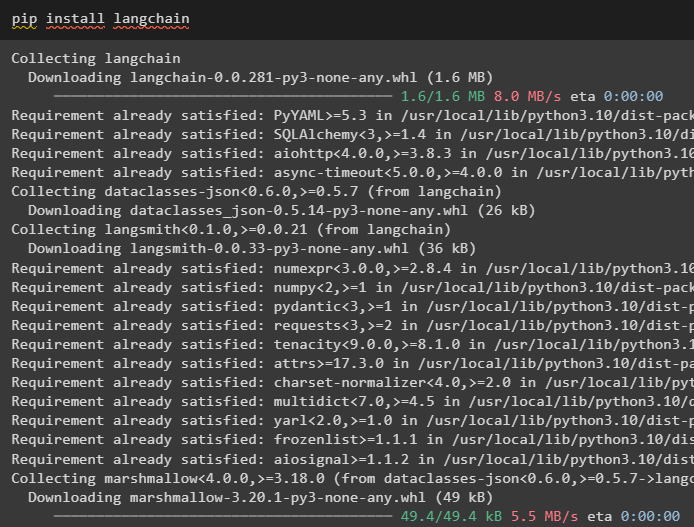

Vaihe 1: Asenna LangChain

Aloita ensin LangChain-sovellusten rakentaminen asentamalla LangChain-kehys käyttämällä ' pip 'komento:

pip asennus langchain

Vaihe 2: Käytä kehotemallia

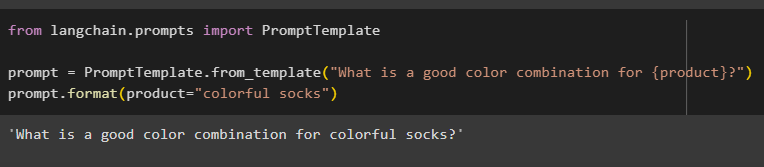

LangChain-moduulien asennuksen jälkeen tuo ' PromptTemplate ”-kirjastosta kehotemallin rakentamiseen tarjoamalla mallille kyselyn ymmärtämään kysymystä:

langchain.promptsista tuo PromptTemplate

prompt = PromptTemplate.from_template('Mikä on hyvä väriyhdistelmä {tuotteelle}?')

prompt.format(product='värikkäät sukat')

Tulos yhdistettiin automaattisesti lauseen arvoon ' tuote ”muuttuja:

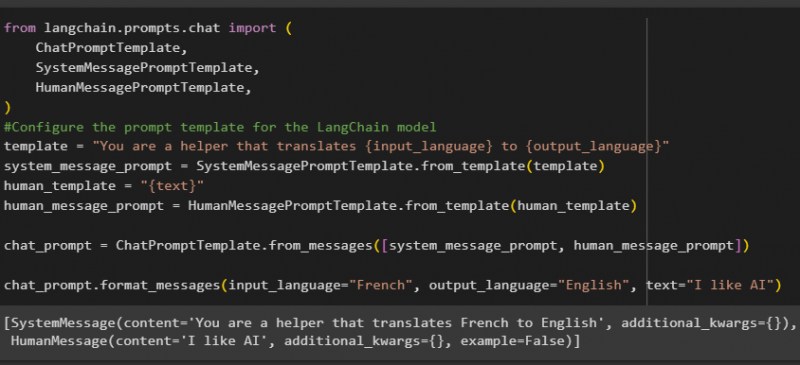

Luo sen jälkeen toinen kehotemalli tuomalla HumanMessagePromptTemplate-, ChatPromptTemplate- ja SystemMessagePromptTemplate-kirjastot LangChainista:

langchain.prompts.chat importista (ChatPromptTemplate,

SystemMessagePromptTemplate,

HumanMessagePromptTemplate,

)

#Määritä kehotemalli LangChain-mallille

template = 'Olet apulainen, joka kääntää {input_language} kielelle {output_language}'

system_message_prompt = SystemMessagePromptTemplate.from_template(malli)

human_template = '{teksti}'

human_message_prompt = HumanMessagePromptTemplate.from_template(ihmisen_malli)

chat_prompt = ChatPromptTemplate.from_messages([system_message_prompt, human_message_prompt])

chat_prompt.format_messages(input_language='ranska', output_language='englanti', text='Pidän tekoälystä')

Kun olet tuonut kaikki tarvittavat kirjastot, luo yksinkertaisesti mukautettu malli kyselyille mallimuuttujan avulla:

Kehotemalleja käytetään vain mallin asettamiseen kyselylle/kysymykselle, eikä se vastaa kysymykseen millään tavalla. OutputParser()-funktio voi kuitenkin poimia vastauksia, kuten seuraavassa osassa esimerkissä selitetään:

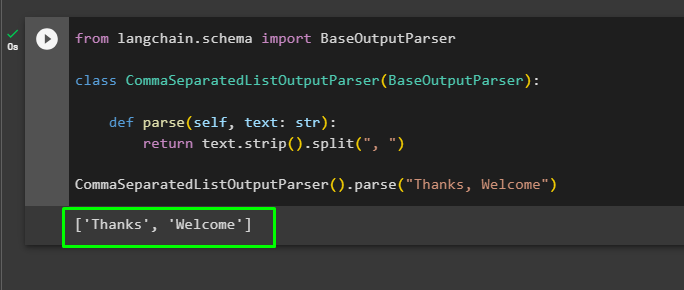

Vaihe 3: Output Parserin käyttäminen

Tuo nyt BaseOutputParser-kirjasto LangChainista erotellaksesi pilkuilla erotetut tekstiarvot ja palauttaaksesi luettelon tulosteessa:

langchain.schema-tuo BaseOutputParserluokka CommaSeparatedListOutputParser(BaseOutputParser):

def jäsentää (itse, teksti: str):

palauttaa text.strip().split(', ')

CommaSeparatedListOutputParser().parse('Kiitos, tervetuloa')

Siinä on kyse LangChain-sovelluksen rakentamisesta kehotemallin ja tulosten jäsentimen avulla.

Johtopäätös

Jos haluat rakentaa LangChain-sovelluksen kehotemallin ja tulosten jäsentimen avulla, asenna LangChain ja tuo kirjastoja siitä. PromptTemplate-kirjastoa käytetään kyselyn rakenteen rakentamiseen, jotta malli voi ymmärtää kysymyksen ennen tietojen poimimista Parser()-funktiolla. OutputParser()-funktiota käytetään vastausten hakemiseen aiemmin mukautettujen kyselyiden perusteella. Tässä oppaassa on selitetty LangChain-sovellusten rakentamisprosessi kehotemallin ja tulosten jäsentimen avulla.