Tässä blogissa keskitymme tapoihin, joilla voit lisätä GPU-käyttöä PyTorchissa.

Kuinka lisätä GPU-käyttöä PyTorchissa?

On olemassa useita tekniikoita, joilla voidaan lisätä GPU-käyttöä ja varmistaa, että parhaita laitteistoresursseja käytetään monimutkaisten koneoppimismallien käsittelyyn. Nämä taktiikat sisältävät koodin muokkaamisen ja PyTorchin ominaisuuksien hyödyntämisen. Alla on lueteltu joitakin tärkeitä vinkkejä ja temppuja:

- Ladataan tietoja ja eräkokoja

- Vähemmän muistia käyttävät mallit

- PyTorch Lightning

- Säädä suoritusajan asetuksia Google Colabissa

- Tyhjennä välimuisti optimointia varten

Ladataan tietoja ja eräkokoja

' Tietojen latausohjelma ” PyTorchissa käytetään määrittämään prosessoriin ladattavien tietojen spesifikaatiot syväoppimismallin jokaisella eteenpäinsiirrolla. Isompi' erän koko ” dataa vaatii enemmän prosessointitehoa ja lisää käytettävissä olevan GPU:n käyttöä.

Syntaksi Dataloaderin määrittämiseksi tietyllä eräkoolla PyTorchissa mukautetulle muuttujalle on annettu alla:

Increase_GPU_Utilization = DataLoader ( erän_koko = 32 )

Vähemmän muistia käyttävät mallit

Jokainen malliarkkitehtuuri vaatii eri määrän ' muisti ” suorittaakseen optimaalisella tasollaan. Mallit, jotka käyttävät tehokkaasti vähemmän muistia aikayksikköä kohden, pystyvät työskentelemään eräkokojen kanssa, jotka ovat paljon suurempia kuin muut.

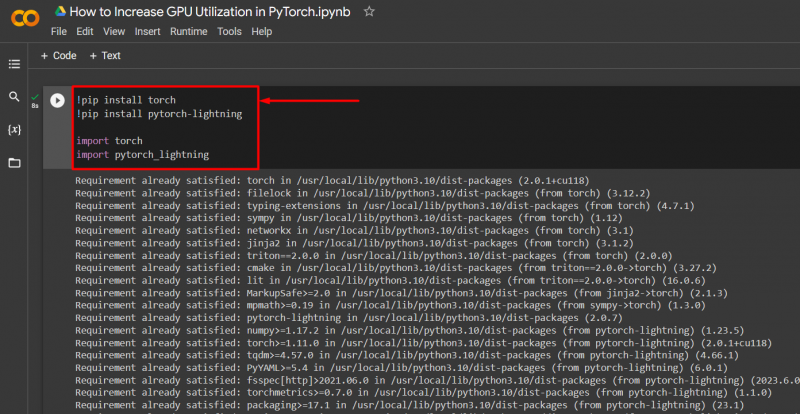

PyTorch Lightning

PyTorchilla on pienennetty versio, joka on ' PyTorch Lightning ”. Se on optimoitu salamannopeaa suorituskykyä varten, kuten sen nimestä käy ilmi. Lightning käyttää oletusarvoisesti GPU:ita ja tarjoaa paljon nopeamman käsittelyn koneoppimismalleille. Lightningin suuri etu on se, että käsittelyä voi haitata vakiokoodivaatimusten puuttuminen.

Tuo tarvittavat kirjastot PyTorch-projektiin alla annetulla syntaksilla:

! pip asennus taskulamppu

! pip asennus pytorch - salama

tuonti taskulamppu

tuonti pytorch_lightning

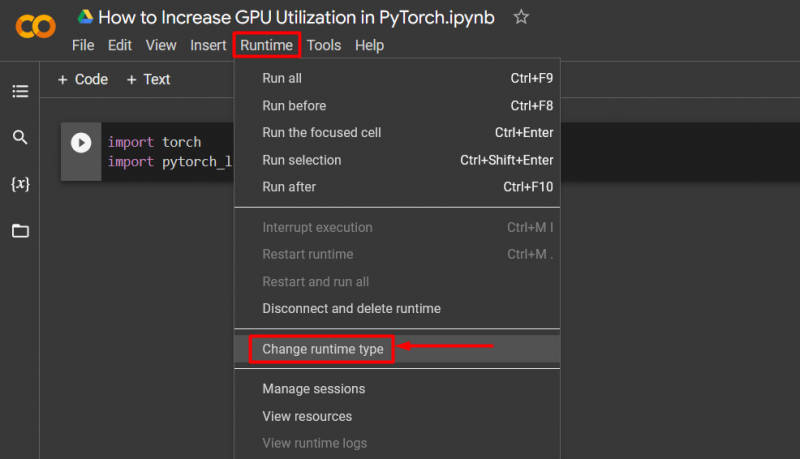

Säädä suoritusajan asetuksia Google Colabissa

Google Colaboratory on pilvi-IDE, joka tarjoaa käyttäjilleen ilmaisen GPU-pääsyn PyTorch-mallien kehittämiseen. Colab-projektit ovat oletusarvoisesti käynnissä suorittimella, mutta asetuksia voidaan muuttaa.

Avaa Colab-muistikirja ja siirry kohtaan ' Suoritusaika ' -vaihtoehto valikkorivillä ja vieritä alas kohtaan ' Muuta suoritusajan asetuksia ':

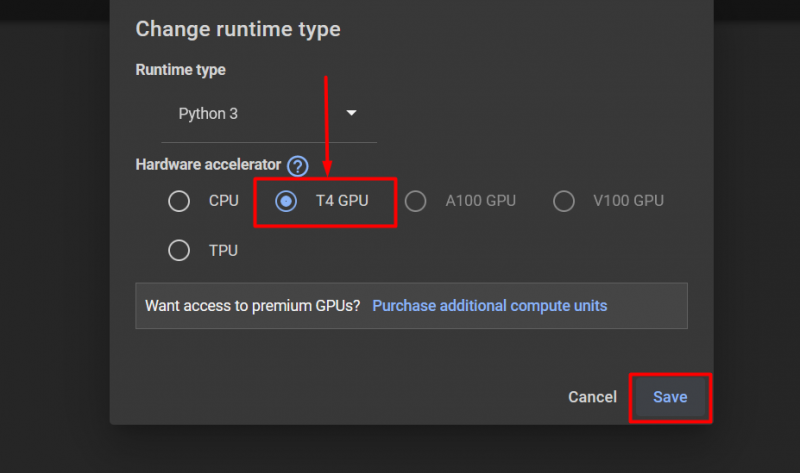

Valitse sitten 'T4 GPU' vaihtoehto ja napsauta ' Tallentaa ' ottaaksesi muutokset käyttöön GPU:n käyttämiseksi:

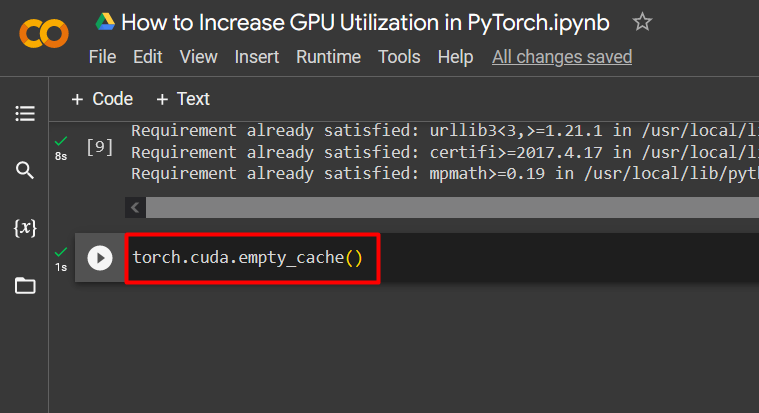

Tyhjennä välimuisti optimointia varten

PyTorchin avulla käyttäjät voivat tyhjentää välimuistin, jotta he voivat vapauttaa tilaa uusille prosesseille. ' Kätkö ” tallentaa tietoja ja tietoja ajettavista malleista, jotta se voi säästää aikaa, joka kuluu näiden mallien uudelleenlataukseen. Välimuistin tyhjentäminen antaa käyttäjille enemmän tilaa uusien mallien ajamiseen.

GPU-välimuistin tyhjennyskomento annetaan alla:

taskulamppu. eri . tyhjä_välimuisti ( )

Näitä vinkkejä käytetään koneoppimismallien optimointiin PyTorchin GPU:illa.

Pro-Tip

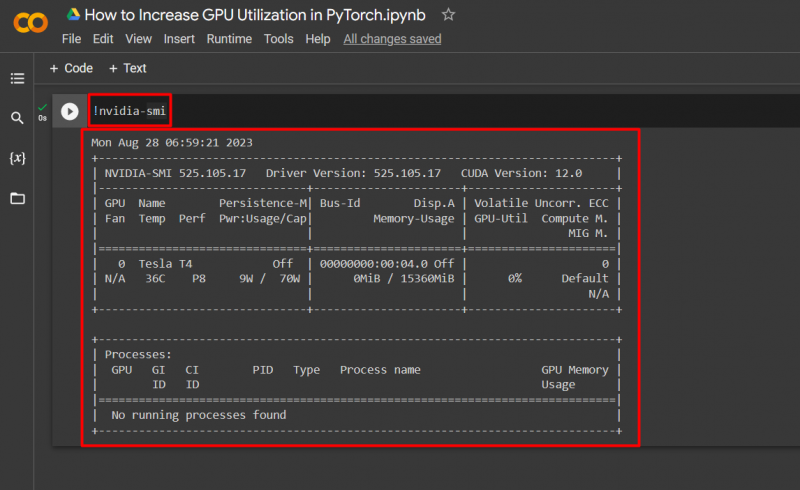

Google Colab antaa käyttäjilleen mahdollisuuden tarkastella grafiikkasuorittimen käyttöä koskevia tietoja ' nvidia ” saadaksesi tietoa siitä, missä laitteistoresursseja käytetään. Komento näyttää GPU:n käyttötiedot alla on annettu:

! nvidia - smi

Menestys! Olemme juuri osoittaneet muutamia tapoja lisätä GPU-käyttöä PyTorchissa.

Johtopäätös

Lisää PyTorchin GPU-käyttöä poistamalla välimuisti, käyttämällä PyTorch Lightningia, säätämällä ajonaika-asetuksia, käyttämällä tehokkaita malleja ja optimaalisia eräkokoja. Nämä tekniikat takaavat pitkälle, että syväoppimismallit toimivat parhaimmillaan ja pystyvät tekemään päteviä johtopäätöksiä ja päätelmiä saatavilla olevasta tiedosta. Olemme osoittaneet tekniikat GPU-käytön lisäämiseksi.